Circunstancias de entrenamiento

Durante la pandemia de 2020, el departamento de Educación de Gran Bretaña dejó en manos de un algoritmo las calificaciones del alumnado; las notas descendieron casi un 40% de media y los medios publicaron que se perjudicó en especial al alumnado de entornos más desfavorecidos. Tras una enorme polémica, los resultados fueron anulados. Anteriormente, Amazon empleó hasta 2018 un sistema de contratación que favorecía a los candidatos masculinos; ese sistema se entrenó con currículos anteriores, la mayoría de los cuales eran de hombres, por lo que aprendió a favorecer a los candidatos masculinos, lo que implicó que mujeres cualificadas ni siquiera tuvieran la oportunidad de una entrevista.

Estos dos casos, entre muchos, muestran cómo debemos permanecer en alerta ante las consecuencias de las cadenas de decisión automatizadas. En el desarrollo de la IA, numerosas noticias nos advirtieron sobre resultados desviados, sorprendentes, alejados de la verdad histórica o maliciosos y sus consecuencias en nuestra realidad cotidiana. Esta dimensión menos luminosa convive con las posibilidades más fascinantes que se abren con el impulso de la IA generativa en los últimos años.

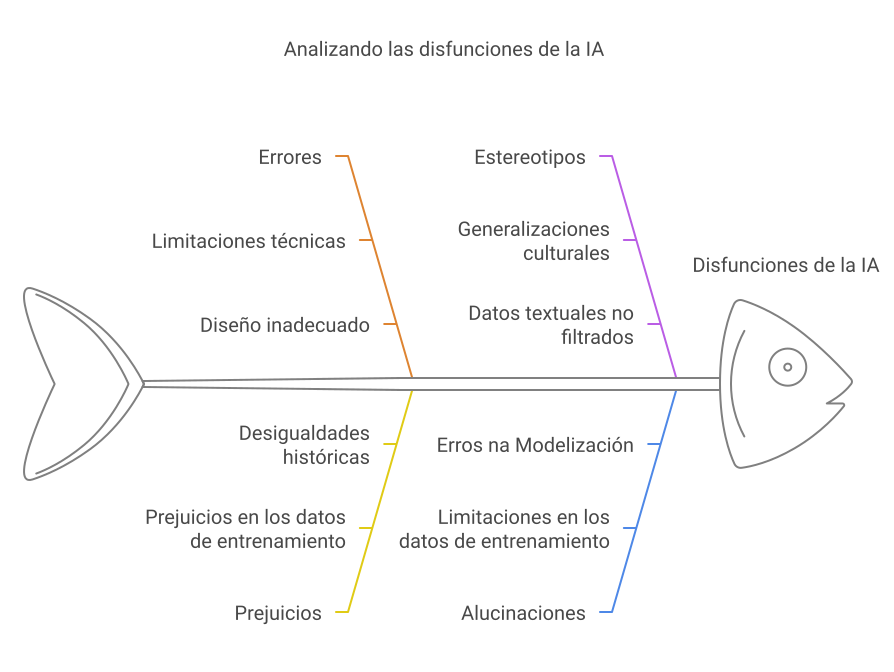

De los productos y resultados que obtenemos de las IA generativas, conviene distinguir entre errores, prejuicios y estereotipos, además de un fenómeno de error no motivado y sorprendente que nos causa asombro y que comúnmente llamamos alucinaciones. Examinaremos estos apartados:

- Errores en la IA: Se explican como fallos en la interpretación o respuesta, con ejemplos como un chatbot que da respuestas equivocadas o un automóvil autónomo que no detecta peatones, debido a limitaciones técnicas o diseño inadecuado.

- Prejuicios en la IA: Se describen como inclinaciones en los datos de entrenamiento que afectan las decisiones, con un ejemplo claro: una IA entrenada con datos donde la mayoría de los médicos son hombres podría asumir que todos los médicos son hombres, dificultando el reconocimiento de las doctoras.

- Estereotipos en la IA: Se definen como generalizaciones culturales, como asociar personalidades concretas o roles específicos con colectivos perpetuadas por datos textuales no filtrados.

- Alucinación en la IA: Fenómeno en el que un sistema de inteligencia artificial genera información falsa, incoherente o sin base real, presentándola como verídica. Estas alucinaciones pueden producirse por limitaciones en los datos de entrenamiento, errores en la modelización o deficiencias en la interpretación del contexto. ```html

Errores

Un error en una inteligencia artificial (IA) surge cuando, debido a limitaciones técnicas o a defectos en su diseño, el sistema interpreta de manera incorrecta una consulta o genera respuestas sin lógica aparente. Estos fallos son especialmente evidentes en situaciones que requieren una comprensión contextual profunda o la capacidad de discernir ambigüedades. Por ejemplo, un asistente virtual entrenado principalmente con datos estructurados podría tener dificultades para procesar preguntas con múltiples intenciones o lenguaje coloquial, llevando a resultados confusos o contradictorios. Aunque estos errores no son intencionados, reflejan la complejidad de replicar el razonamiento humano en máquinas.

Además, los errores técnicos pueden agravarse en sistemas que operan en tiempo real o con fuentes de datos dinámicas, como las IA empleadas en diagnóstico médico o gestión de emergencias. Un fallo en el procesamiento de señales vitales o en la interpretación de protocolos de seguridad podría tener consecuencias graves, incluso en escenarios bien delimitados. Por eso, la monitorización constante y la actualización de los modelos son esenciales para minimizar riesgos y garantizar que las IA se adapten a nuevos desafíos sin comprometer su eficacia.

Prejuicios

Los prejuicios en las IA son distorsiones sistemáticas que se heredan de los datos de entrenamiento, reproduciendo información deficiente derivada de sesgos históricos o culturales. Estos no solo se limitan a cuestiones de género; también pueden reflejar desigualdades étnicas, socioeconómicas o geográficas. Por ejemplo, un algoritmo de selección de personal entrenado con datos de empresas donde predominan ciertos grupos demográficos podría descalificar candidatos competentes por motivos no relacionados con sus habilidades, como el dialecto o el origen. La invisibilidad de estos sesgos hace que sean especialmente peligrosos, ya que se normalizan bajo la apariencia de objetividad algorítmica.

Más allá del ámbito laboral, los sesgos pueden influir en aplicaciones críticas como la justicia predictiva o la concesión de créditos. Si un sistema se entrena con datos que reflejan prácticas discriminatorias, como sentencias más duras para determinadas comunidades, la IA perpetuará esas injusticias bajo la falsa premisa de la neutralidad tecnológica. Combatirlos requiere no solo diversificar las fuentes de datos, sino también incorporar perspectivas éticas en el diseño y validación de los modelos, asegurando que la tecnología no amplifique las desigualdades existentes.

Estereotipos

Los estereotipos en las IA son simplificaciones que reducen realidades complejas a categorías rígidas y, frecuentemente, desactualizadas. Estas generalizaciones, alimentadas por datos históricos o culturales, refuerzan roles sociales dañinos. Por ejemplo, un sistema de generación de imágenes que asocie siempre "científico" con hombres de etnia blanca o "trabajador doméstico" con mujeres latinoamericanas no solo limita la representación, sino que invisibiliza la diversidad real de estas profesiones. El impacto es especialmente notable en herramientas educativas, donde los estereotipos pueden influir en la autopercepción y aspiraciones de niños y adolescentes.

Además, los estereotipos no se limitan a cuestiones de género o profesiones. Pueden manifestarse en asociaciones lingüísticas, como vincular ciertos acentos o dialectos a niveles de educación inferior, o en recomendaciones de contenido que reflejen prejuicios culturales. Para combatir esto, es necesario incorporar datos interseccionales y promover la participación de equipos diversos en el desarrollo de estas tecnologías, asegurando que las IA no repliquen visiones reduccionistas de la sociedad

Alucinaciones

Las alucinaciones de las IA son respuestas plausibles en forma pero falsas en fondo, generadas a partir de correlaciones estadísticas sin comprensión real del contenido. Un ejemplo flagrante sería un modelo lingüístico que asegure que Galicia es un país tropical con playas de arena rosa, combinando elementos reales (como la referencia a playas) con invenciones fantasiosas. Este fenómeno es inherente a las arquitecturas basadas en probabilidades, donde la fluidez del texto se prioriza sobre la exactitud, especialmente en temas poco representados en los datos de entrenamiento.

Estos errores inventados son particularmente problemáticos en contextos que demandan rigor, como la divulgación científica o el asesoramiento legal. Un chatbot médico podría recomendar "terapias" basadas en estudios inexistentes, o un sistema jurídico automático citar leyes fantasmas con artículos convincentes pero ficticios. La solución no es simple: requiere mejorar la transparencia de los modelos, implementar sistemas de verificación en tiempo real y educar a los usuarios sobre las limitaciones de estas herramientas, evitando que se interprete la elocuencia como indicio de fiabilidad.

La presencia de esas disfunciones en los resultados de la inteligencia artificial (IA) demuestra la necesidad de mantener una actitud crítica frente a sus productos. Aunque muchas IAs incluyen mensajes explícitos advirtiendo que pueden cometer errores, las personas tendemos a confiar en exceso en sus respuestas. La investigación en psicología y ética tecnológica ha identificado, además, diversas consecuencias negativas derivadas de nuestra relación con estas tecnologías.

Atribución de autoridad

Uno de los efectos más relevantes es la atribución de autoridad a las decisiones o recomendaciones generadas por sistemas automatizados. Este fenómeno se debe, en gran parte, a la percepción social de la tecnología como un conocimiento científico o técnico superior. Cuando una innovación tecnológica —como la IA— se presenta como avanzada, asumimos que sus resultados son más precisos o fiables, incluso sin evaluar críticamente su validez.

Asimilación de prejuicios

Otro efecto preocupante es la adopción de los prejuicios presentes en los resultados de la IA que no estaban presentes previamente en una persona o colectivo. Se indicó antes que estos sistemas aprenden a partir de datos existentes, que pueden contener prejuicios y estereotipos. Como resultado, no solo refuerzan ideas preexistentes en quienes ya poseen determinadas creencias, sino que también pueden influir en aquellos que no tenían opiniones formadas al respecto. La falta de conciencia sobre este proceso lleva a muchas personas a aceptar los sesgos de la IA como verdades objetivas, incorporándolos a su marco de pensamiento sin cuestionamiento.

En el caso de la esfera pública, la preocupación por la calidad del debate es un punto clave. Pues el objetivo es capturar la atención del usuario, los algoritmos de IA pueden amplificar información sesgada o directamente falsa, pero que logre interés si no se supervisan o se regulan adecuadamente. Un sistema de recomendación de noticias, por ejemplo, que detecte que un usuario suele leer contenido sensacionalista podría reforzar esa tendencia, mostrándole cada vez más información de la misma índole y limitando su acceso a fuentes diversas. Esta falta de diversidad informativa puede influir en la percepción de la realidad social y fomentar la polarización ideológica.

Lectura facilitada

Problemas nas Intelixenias Artificiais: Exemplos e Consecuencias

Durante a pandemia de 2020, o goberno británico usou un algoritmo para calcular as notas dos estudantes. O sistema baixou as cualificacións nun 40% e prexudicou especialmente a alumnos de zonas pobres. Tras moitas queixas, os resultados anuláronse. Outro exemplo é Amazon, que até 2018 usou un sistema de contratación que prefería a homes. Como se adestrou con currículos de homes, o algoritmo desbotaba mulleres cualificadas sen darlles oportunidade.

Erros, Sesgos e Outros Problemas nas IA

As intelixenias artificiais (IA) poden cometer erros cando non entenden ben as preguntas ou dan respostas confusas. Por exemplo, un chatbot pode responder algo equivocado se non recoñece a linguaxe coloquial. Tamén existen sesgos: se unha IA adístrase con datos antigos onde os médicos eran maioría homes, pode ignorar ás mulleres doutoras. Os estereotipos son ideas simplistas, como asociar "enfermeira" só con mulleres. Ademais, as alucinacións son respostas inventadas que parecen certas pero son falsas, como dicir que Galicia ten praias de area rosa.

Por que confiamos demais nas IA?

Moitas persoas cren que as IA sempre teñen razón porque parecen avanzadas. Isto chámase atribución de autoridade. Por exemplo, se un sistema di que unha noticia é certa, podemos crelo sen dubidar, mesmo se é falsa. Outro problema é a asimilación de prexuízos: as IA aprenden de datos con ideas discriminatorias e poden transmitilas á xente. Se un algoritmo mostra só noticias sensacionalistas, a xente pensa que todo é así e ignora outras perspectivas.

Como Evitar Estes Problemas?

Para mellorar as IA, debemos:

- Usar datos máis diversos e actualizados.

- Revisar os sistemas para detectar erros ou ideas preconcebidas.

- Educar ás persoas para que non confíen cegamente nas respostas automatizadas.

É importante recordar que as IA son ferramentas creadas por humanos e poden cometer erros. Debemos usalas con cautela e sentido crítico.