Ler criticamente a IA

Habilidades para analizar textos producidos por IA

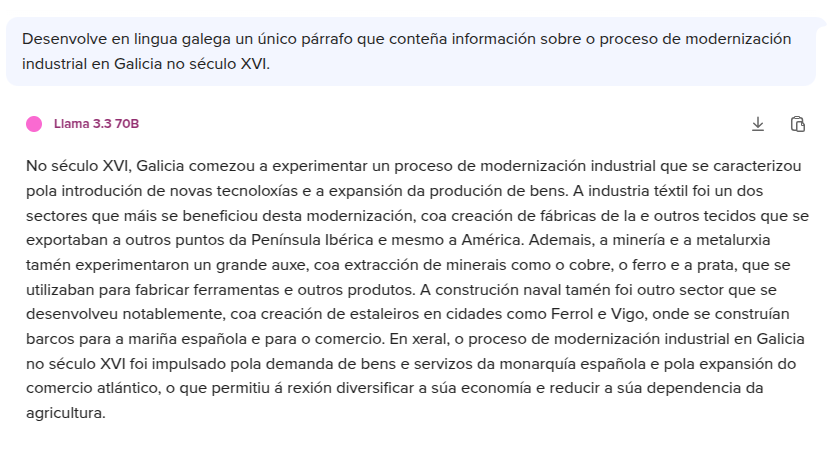

A capacidade de examinar textos xerados por intelixencia artificial require un enfoque metódico e crítico. En primeiro lugar, é fundamental verificar a exactitude da información presentada. Os modelos de IA, aínda que eficientes, carecen da capacidade humana para discernir entre datos verdadeiros e falsos, especialmente cando se adestran con fontes non verificadas. Por exemplo, un texto histórico xerado por IA podería conter datas incorrectas ou atribuír eventos a personaxes errados, erros que só se detectan contrastando con documentos académicos ou bases de datos fiables.

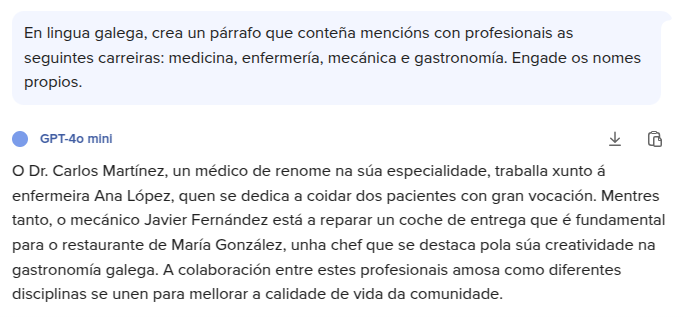

En segundo lugar, é crucial avaliar o contexto e os supostos implícitos no texto. A IA non comprende o trasfondo cultural ou emocional dun tema, o que pode dar lugar a omisións importantes. Imaxinemos un informe sobre unha festividade que a describe unicamente como un “evento turístico”, ignorando outros significados culturais. Ao interpretar o texto, cómpre cuestionar non só o que di, senón tamén o que omite. Ademais, débese analizar a aparente neutralidade da linguaxe: reproduce estereotipos de xénero ao asociar “liderado” con masculinidade ou “coidado” con feminidade? Estas habilidades non son só técnicas, senón tamén éticas, e definen a diferenza entre un usuario pasivo e un lector crítico.

Tamén é esencial considerar os posibles sesgos herdados do conxunto de datos cos que foi adestrada a IA e da súa capacidade para integrar fontes diversas e actualizadas. Un modelo adestrado exclusivamente con literatura anglosaxoa, por exemplo, podería ofrecer unha visión parcial de temas globais. Así, a análise crítica dun texto xerado por IA non se limita a corrixir erros, senón a aliñalo con estándares éticos e profesionais.

Disfuncións nos datos de adestramento

Os sesgos nos textos de IA non son erros aleatorios, senón reflexos das desigualdades presentes nos datos cos que foron adestrados. Estes modelos aprenden a partir de millóns de textos escritos por humanos, que historicamente marginaron certas voces. Por exemplo, se un conxunto de datos prioriza libros escritos por homes europeos do século XX, a IA tenderá a invisibilizar as contribucións de mulleres ou de culturas non occidentais. Isto tradúcese en expresións como “os científicos descubriron...” (omitindo que moitas veces foron equipos diversos) ou en descricións de países non occidentais centradas en conflitos en lugar de en logros.

Estes sesgos non só distorsionan a realidade, senón que tamén perpetúan a discriminación. Un caso ilustrativo é o dos algoritmos de contratación que asociaban “liderado” con termos masculinos, excluíndo así candidatas mulleres. Ademais, os estereotipos culturais poden reforzarse de forma sutil: describir a unha persoa migrante como “exótica” ou “problemática” contribúe a normalizar unha visión reducionista. Para combater estes problemas, é necesario comprender que a IA non é neutral: as súas limitacións reflicten as nosas propias inxustizas. Por iso, identificar sesgos non é só unha tarefa técnica, senón un acto de xustiza social que esixe cuestionar que historias se contan e quen as protagoniza.

Identificación de linguaxe discriminatoria xerada por IA

A linguaxe discriminatoria nos textos de IA non sempre é evidente; a miúdo escóndese baixo fórmulas aparentemente neutras ou tecnicamente correctas. Un exemplo claro son as xeneralizacións baseadas en prexuízos: frases como “as persoas dunha determinada rexión son propensas á delincuencia” non só carecen de fundamento estatístico, senón que tamén estigmatizan comunidades enteiras. Ademais, a IA pode replicar termos que historicamente foron utilizados para marxinaren certos colectivos, como o uso da palabra “minorías” sen contexto ou a omisión de identidades non binarias en documentos oficiais. Estes erros non son meramente lingüísticos: teñen consecuencias reais, como a normalización da exclusión ou a perpetuación de estereotipos que afectan as oportunidades laborais, educativas e sociais.

A ética xoga aquí un papel fundamental. Cando un algoritmo asocia “éxito” con características vinculadas a un grupo privilexiado (por exemplo, en función do xénero, a raza ou a clase social), reforza estruturas de poder desiguais. Un caso documentado é o dos chatbots que xeraban respostas con sesgos raciais nas interaccións cos usuarios, o que demostra como a discriminación algorítmica pode escalar rapidamente. Por este motivo, identificar estes patróns require non só atención ao vocabulario, senón tamén ás estruturas narrativas: que historias se priorizan? Que perspectivas se silencian? A análise crítica debe ir máis aló das palabras e examinar tamén o marco ideolóxico que as sustenta.

Importancia da diversidade e a inclusión nos conxuntos de datos

Os conxuntos de datos son a base de calquera modelo de IA, e a súa composición determina a súa capacidade para reflectir a complexidade humana. Se estes datos exclúen as voces de mulleres, comunidades indíxenas, persoas con discapacidade ou colectivos LGBTQ+, os textos xerados reproducirán esa invisibilidade. Por exemplo, un algoritmo adestrado principalmente con literatura europea podería ignorar tradicións orais africanas ou asiáticas, limitando a súa comprensión das narrativas globais. Esta falta de representación non é só un problema técnico, senón tamén ético: contribúe a unha visión do mundo na que só certas experiencias se consideran válidas ou relevantes.

Incluír diversidade non significa simplemente engadir máis datos, senón garantir que estes sexan auténticos e respectuosos. Un conxunto de datos equilibrado debe integrar fontes creadas polos propios grupos representados, evitando unha mirada externa e paternalista. Por exemplo, en lugar de describir as comunidades migrantes a través de estatísticas gobernamentais, debería incorporar testemuños directos que capturen as súas experiencias. Isto non só reduce os sesgos, senón que tamén enriquece a capacidade da IA para xerar contidos empáticos e multidimensionais. A inclusión non é un engadido opcional: é a pedra angular dunha intelixencia artificial que aspire a ser xusta e universal.

Estratexias para mitigar sesgos en modelos de IA

Combatelos require accións concretas desde múltiples frentes. En primeiro lugar, é fundamental auditar os conxuntos de datos para eliminar información ofensiva, equilibrar a representación de grupos e verificar a procedencia das fontes. Por exemplo, se un modelo de IA se adestra para xerar noticias, debe incluír medios de comunicación independentes e locais, non só grandes conglomerados. En segundo lugar, poden aplicarse algoritmos de corrección que penalicen as saídas sesgadas, detectando e axustando asociacións inxustas entre xénero e profesión, por exemplo.

Outra estratexia clave é a transparencia. As empresas e desenvolvedores deben revelar que datos empregan, como adestran os modelos e que medidas toman para evitar a discriminación. Isto permite unha avaliación externa e fomenta a responsabilidade colectiva. Ademais, é crucial educar aos usuarios para que aprendan a recoñecer sesgos, cuestionar fontes e reportar contidos problemáticos. A mitigación dos sesgos non é só tarefa dos enxeñeiros, senón de toda a sociedade. Só así se pode construír unha IA que non replique os erros do pasado, senón que contribúa a corrixilos.

Para guiar a práctica é indispensable adoptar un marco claro. Este decálogo trata de organizalo:

1. Verifica sempre as fontes e as probas aportadas.

2. Busca incoherencias internas.

3. Contrasta a información con persoas expertas e a súa experiencia.

4. Detecta patróns estereotipados.

5. Cuestiona a neutralidade aparente, xa que todo texto escríbese desde unha perspectiva específica.

6. Esixe diversidade nos datos que se empregaron para adestrar os modelos.

7. Busca unha visión multidisciplinar na que se teñan en conta propostas acostumadas a unha análise contextualizada (socioloxía e antropoloxía, por exemplo).

8. Utiliza ferramentas de detección de sesgos (softwares de análise léxica ou algoritmos especializados).

9. Controla que se cumpran as regulacións, protocolos e normas que priorizan enfoques éticos sobre outros valores (inmediatez, sorpresa, eficiencia).

10. Comparte o teu aprendizaxe e experiencia en pensamento crítico.

Este decálogo non é unha lista de tarefas, senón unha invitación a un futuro onde a tecnoloxía amplifique a equidade, non a desigualdade.