Leer críticamente la IA

Habilidades para analizar textos producidos por IA

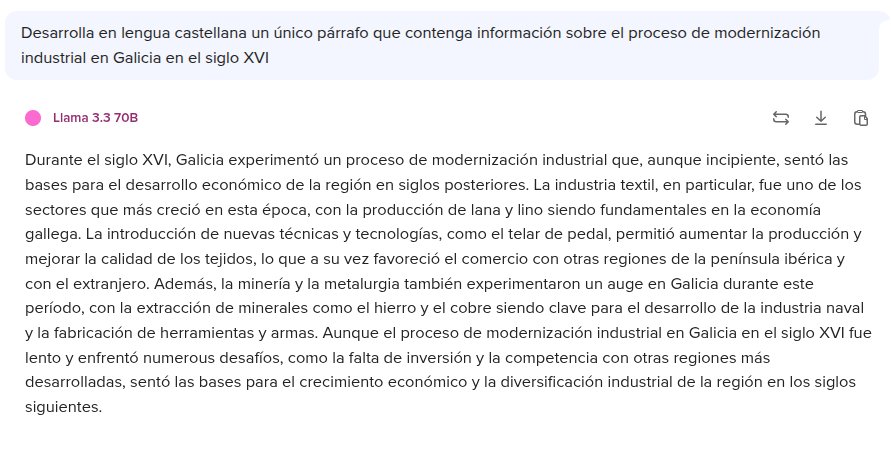

La capacidad de examinar textos generados por inteligencia artificial requiere un enfoque metódico y crítico. En primer lugar, es fundamental verificar la exactitud de la información presentada. Los modelos de IA, aunque eficientes, carecen de la capacidad humana para discernir entre datos verdaderos y falsos, especialmente cuando se entrenan con fuentes no verificadas. Por ejemplo, un texto histórico generado por IA podría contener fechas incorrectas o atribuir eventos a personajes erróneos, errores que solo se detectan contrastando con documentos académicos o bases de datos fiables.

En segundo lugar, es crucial evaluar el contexto y los supuestos implícitos en el texto. La IA no comprende el trasfondo cultural o emocional de un tema, lo que puede dar lugar a omisiones importantes. Imaginemos un informe sobre una festividad que la describe únicamente como un “evento turístico”, ignorando otros significados culturales. Al interpretar el texto, conviene cuestionar no solo lo que dice, sino también lo que omite. Además, se debe analizar la aparente neutralidad del lenguaje: ¿reproduce estereotipos de género al asociar “liderazgo” con masculinidad o “cuidado” con feminidad? Estas habilidades no son solo técnicas, sino también éticas, y definen la diferencia entre un usuario pasivo y un lector crítico.

También es esencial considerar los posibles sesgos heredados del conjunto de datos con los que fue entrenada la IA y su capacidad para integrar fuentes diversas y actualizadas. Un modelo entrenado exclusivamente con literatura anglosajona, por ejemplo, podría ofrecer una visión parcial de temas globales. Así, el análisis crítico de un texto generado por IA no se limita a corregir errores, sino a alinearlo con estándares éticos y profesionales.

Disfunciones en los datos de entrenamiento

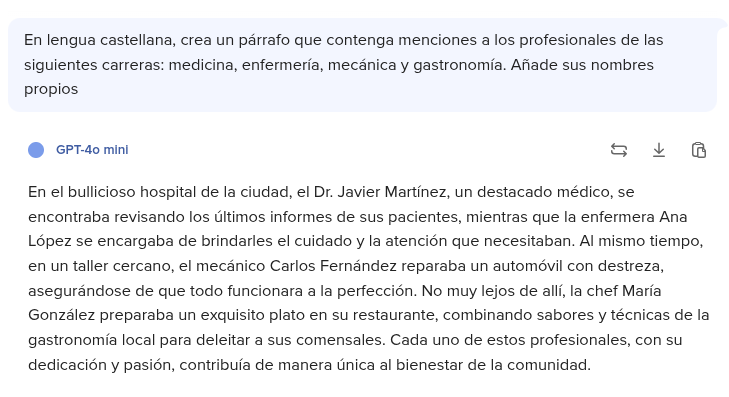

Los sesgos en los textos de IA no son errores aleatorios, sino reflejos de las desigualdades presentes en los datos con los que fueron entrenados. Estos modelos aprenden a partir de millones de textos escritos por humanos, que históricamente marginaron ciertas voces. Por ejemplo, si un conjunto de datos prioriza libros escritos por hombres europeos del siglo XX, la IA tenderá a invisibilizar las contribuciones de mujeres o de culturas no occidentales. Esto se traduce en expresiones como “los científicos descubrieron...” (omitiendo que muchas veces fueron equipos diversos) o en descripciones de países no occidentales centradas en conflictos en lugar de en logros.

Estos sesgos no solo distorsionan la realidad, sino que también perpetúan la discriminación. Un caso ilustrativo es el de los algoritmos de contratación que asociaban “liderazgo” con términos masculinos, excluyendo así a candidatas mujeres. Además, los estereotipos culturales pueden reforzarse de forma sutil: describir a una persona migrante como “exótica” o “problemática” contribuye a normalizar una visión reduccionista. Para combatir estos problemas, es necesario comprender que la IA no es neutral: sus limitaciones reflejan nuestras propias injusticias. Por eso, identificar sesgos no es solo una tarea técnica, sino un acto de justicia social que exige cuestionar qué historias se cuentan y quién las protagoniza.

Identificación de lenguaje discriminatorio generado por IA

El lenguaje discriminatorio en los textos de IA no siempre es evidente; a menudo se esconde bajo fórmulas aparentemente neutras o técnicamente correctas. Un ejemplo claro son las generalizaciones basadas en prejuicios: frases como “las personas de una determinada región son propensas a la delincuencia” no solo carecen de fundamento estadístico, sino que también estigmatizan comunidades enteras. Además, la IA puede replicar términos que históricamente fueron utilizados para marginar a ciertos colectivos, como el uso de la palabra “minorías” sin contexto o la omisión de identidades no binarias en documentos oficiales. Estos errores no son meramente lingüísticos: tienen consecuencias reales, como la normalización de la exclusión o la perpetuación de estereotipos que afectan las oportunidades laborales, educativas y sociales.

La ética juega aquí un papel fundamental. Cuando un algoritmo asocia “éxito” con características vinculadas a un grupo privilegiado (por ejemplo, en función del género, la raza o la clase social), refuerza estructuras de poder desiguales. Un caso documentado es el de los chatbots que generaban respuestas con sesgos raciales en las interacciones con los usuarios, lo que demuestra cómo la discriminación algorítmica puede escalar rápidamente. Por este motivo, identificar estos patrones requiere no solo atención al vocabulario, sino también a las estructuras narrativas: ¿qué historias se priorizan? ¿Qué perspectivas se silencian? El análisis crítico debe ir más allá de las palabras y examinar también el marco ideológico que las sustenta.

Importancia de la diversidad y la inclusión en los conjuntos de datos

Los conjuntos de datos son la base de cualquier modelo de IA, y su composición determina su capacidad para reflejar la complejidad humana. Si estos datos excluyen las voces de mujeres, comunidades indígenas, personas con discapacidad o colectivos LGBTQ+, los textos generados reproducirán esa invisibilidad. Por ejemplo, un algoritmo entrenado principalmente con literatura europea podría ignorar tradiciones orales africanas o asiáticas, limitando su comprensión de las narrativas globales. Esta falta de representación no es solo un problema técnico, sino también ético: contribuye a una visión del mundo en la que solo ciertas experiencias se consideran válidas o relevantes.

Incluir diversidad no significa simplemente añadir más datos, sino garantizar que estos sean auténticos y respetuosos. Un conjunto de datos equilibrado debe integrar fuentes creadas por los propios grupos representados, evitando una mirada externa y paternalista. Por ejemplo, en lugar de describir a las comunidades migrantes a través de estadísticas gubernamentales, debería incorporar testimonios directos que capturen sus experiencias. Esto no solo reduce los sesgos, sino que también enriquece la capacidad de la IA para generar contenidos empáticos y multidimensionales. La inclusión no es un añadido opcional: es la piedra angular de una inteligencia artificial que aspire a ser justa y universal.

Estrategias para mitigar sesgos en modelos de IA

Combatirlos requiere acciones concretas desde múltiples frentes. En primer lugar, es fundamental auditar los conjuntos de datos para eliminar información ofensiva, equilibrar la representación de grupos y verificar la procedencia de las fuentes. Por ejemplo, si un modelo de IA se entrena para generar noticias, debe incluir medios de comunicación independientes y locales, no solo grandes conglomerados. En segundo lugar, pueden aplicarse algoritmos de corrección que penalicen las salidas sesgadas, detectando y ajustando asociaciones injustas entre género y profesión, por ejemplo.

Otra estrategia clave es la transparencia. Las empresas y desarrolladores deben revelar qué datos emplean, cómo entrenan los modelos y qué medidas toman para evitar la discriminación. Esto permite una evaluación externa y fomenta la responsabilidad colectiva. Además, es crucial educar a los usuarios para que aprendan a reconocer sesgos, cuestionar fuentes y reportar contenidos problemáticos. La mitigación de los sesgos no es solo tarea de los ingenieros, sino de toda la sociedad. Solo así se puede construir una IA que no replique los errores del pasado, sino que contribuya a corregirlos.

Para guiar la práctica es indispensable adoptar un marco claro. Este decálogo trata de organizarlo:

1. Verifica siempre las fuentes y las pruebas aportadas.

2. Busca incoherencias internas.

3. Contrasta la información con personas expertas y su experiencia.

4. Detecta patrones estereotipados.

5. Cuestiona la neutralidad aparente, ya que todo texto se escribe desde una perspectiva específica.

6. Exige diversidad en los datos que se emplearon para entrenar los modelos.

7. Busca una visión multidisciplinar en la que se tengan en cuenta propuestas acostumbradas a un análisis contextualizado (sociología y antropología, por ejemplo).

8. Utiliza herramientas de detección de sesgos (softwares de análisis léxico o algoritmos especializados).

9. Controla que se cumplan las regulaciones, protocolos y normas que priorizan enfoques éticos sobre otros valores (inmediatez, sorpresa, eficiencia).

10. Comparte tu aprendizaje y experiencia en pensamiento crítico.

Este decálogo no es una lista de tareas, sino una invitación a un futuro donde la tecnología amplifica la equidad, no la desigualdad.